フォレンジックの成否は「時刻」で決まる:NTP時刻同期と改ざん防止ログ保存設計、SIEM活用まで徹底解説

1分でわかるこの記事の要約 サイバー攻撃調査において、ログの時刻同期がずれているとタイムライン分析が崩壊し、原因究明が困...

更新日:2025年12月11日

1分でわかるこの記事の要約 生成AIの運用には、情報漏洩や著作権侵害といった重大なリスクが潜んでいることを認識する必要があります。 リスクを体系的に管理するためには「人・プロセス・ツール」の三層構造で全体像を把握するのが […]

目次

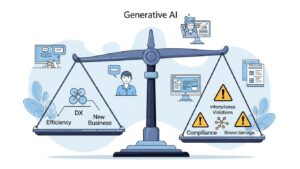

生成AIの活用による業務効率化やDX推進への期待が急速に高まっています。しかし、その強力なポテンシャルの裏側には、情報漏洩やコンプライアンス違反といった、事業の継続性を揺るがしかねない重大な運用リスクが潜んでいます。

この記事でわかること

生成AIは、単なる業務効率化ツールにとどまらず、ビジネスモデルそのものを変革する起爆剤として位置づけられています。市場調査やコンテンツ作成の自動化、ソフトウェア開発の高速化など、その活用範囲は多岐にわたり、多くの企業が導入を検討・推進しています。この大きな変革の波に乗り遅れないためには、積極的なAI技術の活用が不可欠です。

しかし、この技術の急速な進化は、新たな脅威も生み出しています。例えば、社員が機密情報をプロンプトに入力してしまう情報漏洩リスク、生成されたコンテンツが他者の著作権を侵害してしまうコンプライアンスリスク、あるいはAIモデル自体の脆弱性を突いたサイバー攻撃など、これまで想定されてこなかった課題が次々と表面化しています。

これらの生成AIに特有の運用リスクを管理せず放置した場合、その影響は計り知れません。顧客からの信頼失墜、ブランドイメージの低下はもちろんのこと、法規制違反による多額の罰金や訴訟といった法的責任を問われる可能性もあります。最悪の場合、事業の継続性そのものが危ぶまれる事態に発展しかねません。

だからこそ、DX推進と表裏一体の課題として、組織全体で生成AIの運用リスクに向き合い、適切なAIガバナンス体制を構築することが、今まさに求められているのです。

複雑で多岐にわたる生成AIの運用リスクを効果的に管理するためには、まずその全体像を正確に把握することが第一歩です。そこで有効な手法となるのが「リスクマップ」の作成です。

リスクマップとは、洗い出された様々なリスクを「発生可能性」と「影響度」の2つの軸で評価し、マトリクス上に配置することで、どのリスクに優先的に対応すべきかを可視化するツールです。これにより、漠然とした不安を具体的な課題に落とし込み、客観的なデータに基づいたリスク分析と対策立案が可能になります。

特に生成AIの運用においては、技術的な問題だけでなく、利用者のリテラシーや社内プロセスなど、多様な要因がリスクにつながります。リスクマップを用いることで、これらの複雑に絡み合ったリスクの相関関係や優先順位を組織全体で共有し、効果的なIT運用・システム運用リスク管理体制の構築に向けた共通認識を形成する上で極めて重要な役割を果たします。

生成AIの運用リスクをより網羅的かつ体系的に分析するために、本記事では「人・プロセス・ツール」という三層構造のアプローチを提唱します。このフレームワークを用いることで、リスクの見落としを防ぎ、それぞれの階層に応じた最適な対策を講じることが可能になります。

この三層構造でリスクを整理することで、一つのインシデントがどの階層の問題に起因するのかを明確にし、根本的な原因解決につなげることができるのです。

それでは、「人・プロセス・ツール」の各階層に潜む具体的な運用リスクと、それらに対する有効な対策を詳しく見ていきましょう。

最も発生頻度が高く、対策が急がれるのが「人」に起因するリスクです。どんなに優れたツールやプロセスを導入しても、それを使う人間のリテラシーが低ければ、リスクを完全に防ぐことはできません。

これらの人的リスクへの対策として最も重要なのは、組織全体での人材育成とリテラシー向上です。全従業員を対象に、生成AIの仕組み、潜在的なリスク、そして安全な活用方法に関する研修を定期的に実施することが不可欠です。また、「どのような情報を入力してはいけないか」「生成物をどのように検証すべきか」といった具体的なルールを定めた「ChatGPT 会社利用 ルール」のような利用ガイドラインを策定し、全社に周知徹底することが求められます。

生成AIを安全に業務へ組み込むためには、しっかりとした「プロセス」とそれを支えるガバナンス体制の構築が欠かせません。

プロセスに潜むリスクへの対策は、強固なAIガバナンス体制の構築に集約されます。まず、生成AIの活用を前提とした業務プロセスの見直しと再設計を行います。どこにAIを導入し、どこで人間による判断・承認を介在させるかを明確に定義します。その上で、生成AIの導入・活用に関する全社的な方針やルールを定めたガイドラインを策定し、定期的な見直しを行う体制を整えることが重要です。

最後に、生成AIという「ツール」そのものが持つ技術的なリスクと、そのセキュリティ対策についてです。ここでの対策は、IT部門やシステム運用チームが主導する専門的な領域となります。

これらの技術的リスクへは、まず信頼性の高いAIツールを選定することが基本です。ツールの開発元が講じているセキュリティ対策や、第三者機関による認証(ISO 27001など)の有無を評価基準とします。その上で、定期的な脆弱性診断を実施し、プラットフォームの安全性を継続的に確認します。機密情報を扱う際には、入力データを匿名化・マスキングする技術の導入も有効です。さらに、厳密なアクセス制御や権限管理の徹底も、基本的なセキュリティ対策として重要です。

理論を理解したところで、実際に自社のリスクマップを作成する具体的な手順を4つのステップで解説します。

自社でリスク管理体制を構築する際には、公的機関などが提示しているフレームワークを参考にすることで、より体系的で網羅的なアプローチが可能になります。

特に注目されているのが、米国国立標準技術研究所(NIST)が公開した「AIリスクマネジメントフレームワーク(AI RMF)」です。これは、組織がAIシステムに起因するリスクを管理するための指針を提供するもので、「統治(Govern)」「マップ(Map)」「測定(Measure)」「管理(Manage)」という4つの主要な機能から構成されています。このフレームワークを活用することで、自社のAIガバナンス体制をより高いレベルへと引き上げることができます。

生成AIのリスク管理は、ゼロから新しい体制を作る必要は必ずしもありません。多くの企業では、すでに情報セキュリティマネジメントシステム(ISMS)の国際規格であるISO 27001などに準拠したセキュリティ体制を運用しています。生成AI特有のリスクを、この既存のIT運用・システム運用のリスク管理プロセスに追加・統合することで、効率的かつ効果的に管理体制を強化できます。

生成AIは、ビジネスに革命的な変化をもたらす強力なツールですが、その導入と活用には適切なリスク管理が不可欠です。本記事で解説したように、生成AIの運用リスクは「人・プロセス・ツール」の三層構造で体系的に捉え、リスクマップを用いて可視化することが、効果的な対策を講じるための第一歩となります。

リスクを過度に恐れて活用をためらうのではなく、リスクを正しく理解し、コントロールする体制を構築すること。それこそが、生成AIがもたらす恩恵を最大限に引き出し、持続的な企業成長を実現するための鍵となります。まずは自社の現状を分析し、小さな範囲からでもリスクの洗い出しを始めてみてはいかがでしょうか。

A1: はい、必要です。企業の規模にかかわらず、情報漏洩やコンプライアンス違反のリスクは等しく存在します。むしろ、リソースが限られる中小企業こそ、一度インシデントが発生した際の影響が大きくなる可能性があります。最初から完璧な体制を目指すのではなく、まずは利用ガイドラインの策定や従業員への注意喚起など、着手しやすいところから始めることが重要です。

A2: ガイドラインには、最低限以下の項目を盛り込むことを推奨します。

これらを、具体的な事例を交えて分かりやすく記載することがポイントです。

A3: 一般的に、法人向けの有料版ツールは、無料版に比べてセキュリティやデータ管理の面で高度な機能が提供されています。例えば、入力したデータがAIの学習に利用されない設定(オプトアウト)が標準であったり、アクセスログの管理機能が充実していたりします。無料ツールを手軽に試すことは有効ですが、本格的な業務利用、特に機密情報を扱う可能性がある場合は、セキュリティポリシーが明確で管理機能が豊富な有料版の導入を強く推奨します。

記載されている内容は2025年12月11日時点のものです。現在の情報と異なる可能性がありますので、ご了承ください。また、記事に記載されている情報は自己責任でご活用いただき、本記事の内容に関する事項については、専門家等に相談するようにしてください。

1分でわかるこの記事の要約 サイバー攻撃調査において、ログの時刻同期がずれているとタイムライン分析が崩壊し、原因究明が困...

1分でわかるこの記事の要約 サイバー攻撃の再発防止には、目の前の暫定対処だけでなく、根本原因を取り除く恒久対応への転換が...

1分でわかるこの記事の要約 SOARによるセキュリティ自動化は強力ですが、封じ込め機能には「誤隔離」という重大なリスクが...

1分でわかるこの記事の要約 サイバーキルチェーンに基づくインシデント対応プレイブックは、サイバー攻撃の被害を最小化するた...

1分でわかるこの記事の要約 SIEM検知ルールはログ欠損や形式変更、陳腐化、プラットフォーム更新により機能不全に陥ります...

履歴書の「趣味特技」欄で採用担当者の心を掴めないかと考えている方もいるのではないでしょうか。ここでは履歴書の人事の...

いまいち難しくてなかなか正しい意味を調べることのない「ご健勝」「ご多幸」という言葉。使いづらそうだと思われがちです...

「ご査収ください/ご査収願いします/ご査収くださいますよう」と、ビジネスで使用される「ご査収」という言葉ですが、何...

選考で要求される履歴書。しかし、どんな風に書いたら良いのか分からない、という方も多いのではないかと思います。そんな...

通勤経路とは何でしょうか。通勤経路の届け出を提出したことがある人は多いと思います。通勤経路の書き方が良く分からない...